图/ICChatGPT(生成式预训练转换器)正遭遇“围剿”。4月3日,德国联邦数据保护专员发言人称,出于数据保护方面的考虑,暂时禁止在德国使用ChatGPT原则上是可能的。而3月底,意大利个人数据保护

图/IC

ChatGPT(生成式预训练转换器)正遭遇“围剿”。

4月3日,德国联邦数据保护专员发言人称,出于数据保护方面的考虑,暂时禁止在德国使用ChatGPT原则上是可能的。而3月底,意大利个人数据保护局宣布,从即日起禁止使用聊天机器人ChatGPT,并限制开发这一平台的OpenAI公司处理意大利用户信息。

意大利这一举动,被视作打响了人类保卫战的第一枪,但“封杀”ChatGPT,在意大利高层也引发了激烈讨论。

五天用户破百万,2个月用户上亿,ChatGPT爆火,将生成式AI推上了风口。用户追捧从侧面说明这绝非一次概念炒作,而是实实在在的技术改善,而机器学习算法缔造的生成式AI,具备在横向领域应用的能力——ChatGPT可以是聊天AI(人工智能),也可以应用在编程以及搜索上。针对这种能力有一句口号:万物皆可GPT。

誉满后必然是毁满。早在2022年6月,谷歌一位工程师交上了21页调查报告,认为谷歌AI模型LaMDA已经拥有人格,再训练下去会导致不可预见的后果。如今,ChatGPT同样面临这样的挑战。

担忧AIGC(人工智能生成内容)具备人格并引发灾难的人不在少数。近期,OpenAI创始投资人马斯克联名千人要求“暂停巨型AI实验”,将ChatGPT停留在GPT4.0阶段。连OpenAI的CEO奥特曼都认为,开源GPT算法是非常危险的行为,因为如果被坏人使用将危害无穷。

大家到底在担心什么?第一个层面是ChatGPT可能取代人类,甚至会出现科幻片中清洗人类的危险。这部分担忧实际上源自于科幻,也源自于哲学范畴,对人格和AI人格区别化界定。最早的小说可能是《佛兰肯斯坦》。

第二个层面是ChatGPT可能破坏数据安全。诸如AIGC有爬取数据的功能,这会让数据隐私在互联网时代更加无所遁形。

第三个层面是信息茧房。由ChatGPT引导的信息搜索结果,可能导致新的信息茧房,也就是我们只能获得ChatGPT给予的信息。相比于搜索推荐和内容算法推荐,ChatGPT推送信息更加精准,我们这一代还会手动找一找信息来源,“后浪们”会不会产生依赖?

第四个层面是GPT遭遇滥用危害无穷。万物皆可GPT,GPT会应用到任何领域。如果这项功能被别有用心的人掌握,势必会产生恶劣影响,不亚于恐怖分子掌握了核武器。

实际上,对于取代人类之说,无需忧虑。机器学习下,AI的确是技术黑箱,但说到底还是数学、统计学、计算机学的融合体,是一堆函数和数学模型的最终产物。这种担忧本身来自于科幻,也来自于人类独特的想象力。如果AI是提升人类认知水平和科技水平的一种工具,我们应该用AI来提高认知,应对其他潜在风险,而不是去猜测可能性。

不过,ChatGPT带来的数据安全和信息茧房问题,要给与重视。AIGC说到底是一种工具,而且是一种强大的工具,爬取数据,建立信息茧房和被别有用心的人掌控,造成的破坏不容小觑。直白点说,它会成为收割金钱和利益的工具。

惧怕被收割,就不发展AIGC吗?并非如此,一方面人类从未成功阻止过一项有用技术的发展,技术的进步只会降低工具门槛,最终让技术更加不可控。另一方面,人类应对技术带来的负外部性,一般是靠技术本身。比如,应对核武器的手段就是核武器本身,我们称之为“黑暗森林”。因此,监管AI的方式,在规则层面很难找到突破口,因为AI本身太复杂,只有AI才能监管AI。所以,应鼓励人们早日掌握这些关键技术,应用到关键领域。

对于AIGC的监管有必要,监管目标不应该是AI的人格,而是用AI的人,了解他们想要达到的目的。一定程度上来说,我们不能被封杀AIGC的口号影响,但生成式AI技术的出现不仅带来了巨大机遇,同时也带来了风险。

近年来,随着技术进步,生成式AI在文化创意产业、新闻媒体、金融、医疗等领域得到广泛应用。其一大风险是可能被用于恶意目的,因此,政府、企业和其他相关组织应该加强监管,尽可能地预防生成式AI滥用,要预见风险,提早筑起一道防护墙。

文/盘和林(浙江大学国际联合商学院数字经济与金融创新研究中心联席主任、研究员,工信部信息通信经济专家委员会委员)

编辑 王进雨

校对 柳宝庆

潮汐车道可以掉头吗(潮汐车道地面标线)

潮汐车道可以掉头吗(潮汐车道地面标线)

幻塔赤红花瓣猎取攻略(幻塔赤红花瓣如何取得)

幻塔赤红花瓣猎取攻略(幻塔赤红花瓣如何取得)

泰拉瑞亚海盗船坐骑怎么获得(泰拉瑞亚海盗船坐骑怎么刷)

泰拉瑞亚海盗船坐骑怎么获得(泰拉瑞亚海盗船坐骑怎么刷)

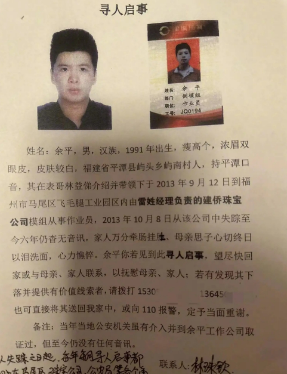

母亲寻子多年儿子疑已身亡(母亲寻子多年儿子疑已身亡)

母亲寻子多年儿子疑已身亡(母亲寻子多年儿子疑已身亡)

天堂岛WWW中文资源在线

天堂岛WWW中文资源在线

马桶堵了但还缓慢下水怎么才能疏通(大便把马桶堵了但还缓慢下水怎么才能疏通)

马桶堵了但还缓慢下水怎么才能疏通(大便把马桶堵了但还缓慢下水怎么才能疏通)

马桶堵了但还缓慢下水怎么才能疏通,网友:疏通方法有这么几个。马桶在生活中我们常会用...

小鸡庄园最新的答案4.5是什么 小鸡庄园最新答题答案2023年4月5日

小鸡庄园最新的答案4.5是什么 小鸡庄园最新答题答案2023年4月5日

小编为大家分享小鸡庄园最新的答案4 5是什么 小鸡庄园最新答题答案2023年4月5日相关内...

一个人免费观看视频www中文()

一个人免费观看视频www中文()

一个人免费观看视频www中文是一款能给你带来全新直播体验的软件,涵盖了互动直播麦、直播...

4399观看视频免费哔哩哔哩漫画:私密浏览器看片大全免费视频

4399观看视频免费哔哩哔哩漫画:私密浏览器看片大全免费视频

大家好,小编推荐的4399观看视频免费哔哩哔哩漫画是一款所有老司机们都可以尽情免费在里...

原神种门伤害来源是什么 原神种门是什么意思

原神种门伤害来源是什么 原神种门是什么意思

小编为大家分享原神种门伤害来源是什么 原神种门是什么意思相关内容,原神如今已经推出了...